Почему важно понимать природу ошибок мышления.

В реальном мире наши решения и убеждения не всегда соответствуют действительности. Мы склонны переоценивать собственные знания, попадаться в ловушки восприятия и защищать ложные убеждения, даже когда факты указывают на обратное. Почему это критически важно? Потому что такие ошибки мышления могут приводить к личным неудачам, бизнес-катастрофам и даже общественным кризисам. Если мы не осознаём собственные когнитивные искажения и иллюзии, то рискуем повторять одни и те же ошибки. Признание своих умственных ловушек – первый шаг к развитию самостоятельного критического мышления и принятию более обоснованных решений.

Даже наш повседневный опыт полон примеров. Человек может уверенно считать, что помнит событие «как оно было на самом деле», хотя память давно его подвела. Или, скажем, кто-то убеждён, что проблема всегда в других людях, а не в его собственных иллюзиях. (Например, можно слышать: «Вам не нужен слишком сильный партнёр – проблема не в них, проблема в ваших иллюзиях», и это зачастую правда.) Вывод: понимание природы таких ошибок – не академическое излишество, а жизненно важный навык. Ниже мы разберём, откуда берутся эти ошибки, какие бывают искажения мышления и как с ними бороться.

Почему мозг ошибается: эволюция, выживание и истина.

Наш мозг сформировался в ходе эволюции не для поиска объективной истины, а для выживания. Это значит, что многие наши познания реальности — лишь полезные с практической точки зрения упрощения или даже иллюзии. Современные исследования в когнитивной науке показывают, что то, как мы воспринимаем мир, лишь отчасти отражает реальность. Например, когнитивист Дональд Хоффман утверждает, что эволюция «вознаграждает» не точное восприятие, а удобные иллюзии: естественный отбор максимизирует приспособленность, «вытесняя правду» . Иными словами, мозг показывает нам упрощённую «виртуальную реальность», помогающую быстро реагировать и выживать, но не обязанную быть верной копией мира.

Кроме того, эволюция, возможно, наделила нас механизмами самообмана. Биолог Роберт Триверс выдвинул гипотезу, что самообман мог развиться как способ лучше обманывать других для собственного блага . Если мы искренне верим в свою ложь, нам легче убедить окружающих. В книге «Обман и самообман» он показывает: обманывая сами себя, мы порой становимся слишком уверены в своей правоте и слепы к истине . Так, человек может игнорировать неприятные факты и видеть только то, что ему выгодно, — эволюционно это могло помогать сохранять решимость и «моральный дух», но в современных условиях приводит к систематическим ошибкам.

Наконец, наш мозг ограничен по ресурсам внимания и вычислений. Чтобы выживать, людям нужна быстрота, а не безупречная логика. Отсюда появляются эвристики – мысленные сокращения. Психолог Даниэль Канеман описал это как взаимодействие двух систем мышления: быстрой интуитивной (System 1) и медленной аналитической (System 2). Быстрая система действует мгновенно и эффективно, но часто ошибается; медленная – точнее, но ленится и включается не всегда. Поэтому в привычной жизни мы полагаемся на интуитивные правила большого пальца. Они сформировались эволюционно и в большинстве ситуаций полезны, но имеют оборотную сторону – систематические смещения. Эти смещения и называются когнитивными искажениями.

Когнитивные искажения: главные ловушки нашего мышления.

Когнитивные искажения – это предсказуемые ошибки мышления, которые возникают из-за того, как наш мозг обрабатывает информацию. По сути, это «бага» восприятия и анализа, свойственные всем людям. Разберём несколько ключевых искажений, которые чаще всего сбивают нас с пути – как они работают и как проявляются в жизни, бизнесе и технологиях.

Склонность к подтверждению своей точки зрения (confirmation bias).

Одно из самых известных искажений – предвзятость подтверждения. Это наша склонность искать и заметать ту информацию, которая подтверждает наши уже существующие убеждения, и игнорировать или принижать значимость сведений, которые им противоречат . Мы любим быть правыми, и мозг услужливо отбирает факты в нашу пользу.

Как это выглядит на практике? Представьте руководителя, убеждённого, что его продукт превосходен. Он будет замечать восторженные отзывы клиентов, но считать единичные жалобы «незначительными» или ошибочными. В результате команда может упустить серьёзные дефекты продукта, ведь негативные сигналы отфильтрованы предвзятостью подтверждения. Пример из истории: компания Kodak долгие годы доминировала на рынке плёнки и «ослепла» к появлению цифровых технологий. Руководство Kodak, довольное прошлым успехом, искало подтверждения, что плёнка ещё долгие годы будет в центре внимания, и отвергало тревожные звоночки о цифровой революции. Когда инженер представил им первый цифровой фотоаппарат, реакция была примерно: «Забавно, но не воспринимайте всерьёз». Руководство удвоило ставки на плёночный бизнес, игнорируя факт, что мир меняется . Эта корпоративная близорукость – классический пример confirmation bias: верить в то, во что хочется верить, и отвергать альтернативы, пока не стало слишком поздно.

Предвзятость подтверждения затрагивает и научную сферу, и нашу личную жизнь. Ученые могут бессознательно уделять больше внимания результатам экспериментов, подтверждающим их гипотезу, и упускать аномальные данные. В бытовом общении мы часто слышим только то, что подкрепляет наши взгляды. В эпоху интернета это выражается в эхо-камерах – мы подписываемся на источники, которые с нами согласны, формируем «пузырь» удобной информации и всё больше убеждаемся в своей правоте. Чтобы противостоять этому искажению, полезно сознательно искать иную точку зрения и задавать себе вопрос: «А что, если я ошибаюсь?».

Ошибка выжившего (survivorship bias).

Ошибка выжившего – ещё одна коварная ловушка. Она заключается в том, что мы делаем выводы, опираясь только на тех, кто «выжил» (успел достичь успеха, пробиться), и не учитываем невидимых «потерпевших неудачу». Как следствие, наши выводы смещаются в сторону оптимизма и переоценки вероятности успеха.

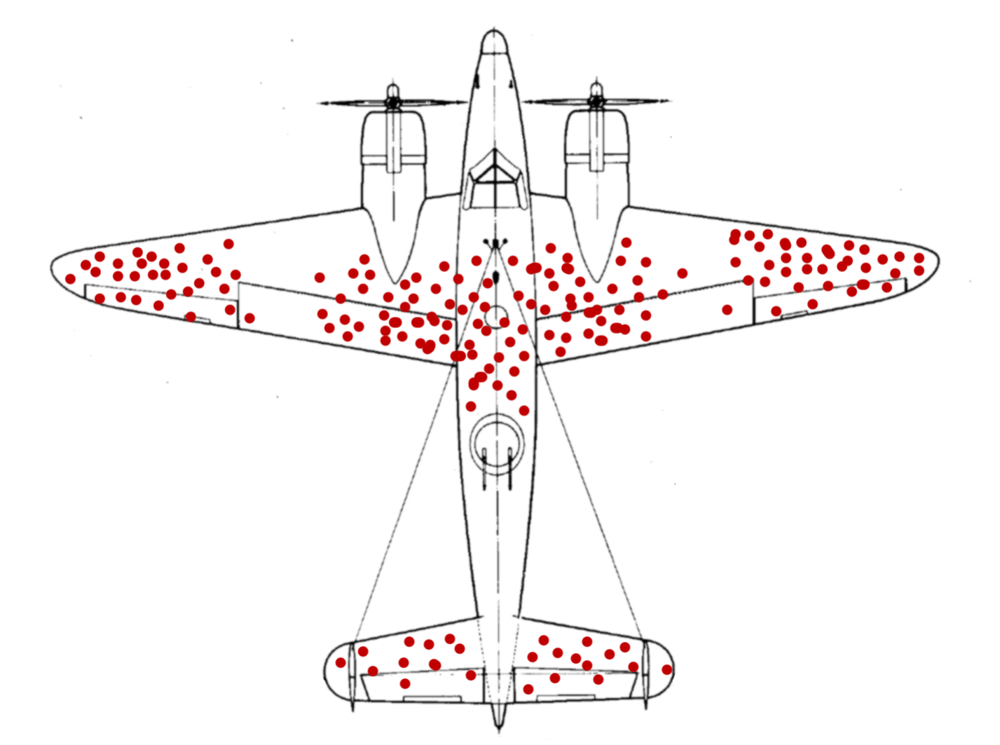

Классический пример пришёл из времён Второй мировой войны. Союзники анализировали повреждения самолётов, возвращающихся с боевых вылетов, чтобы усилить броню. На самолётах были видны отверстия от пуль – особенно крылья, хвост, фюзеляж усеяны пробоинами. Интуитивно напрашивалось: укреплять те места, куда попадают чаще всего. Однако статистик Абрахам Вальд увидел логическую ошибку: ведь рассматриваются только вернувшиеся самолёты. Значит, пробоины на них отмечают области, где самолёт может получить урон и всё же вернуться на базу. А вот те самолёты, что не вернулись, вероятно, получили критические попадания в других местах (например, двигатель или кабину пилота) – и эти области на уцелевших машинах как раз без дыр. Вальд предложил наоборот: усилить неповреждённые участки – именно туда, по его расчетам, стреляли вражеские пушки, отправляя самолёты на дно . Это и есть ошибка выжившего: если смотреть только на успешных, упуская «невидимые» провалы, вывод будет ошибочным.

Пример ошибки выжившего: красные точки показывают попадания по самолёту, вернувшемуся с задания. Уцелевшие машины имели много дыр в крыльях и фюзеляже, поэтому кажется логичным усилить именно их. Однако Вальд указал, что нужно укреплять места, где нет повреждений – попадания туда приводили к гибели самолёта и не видны на этой статистике .

В современном мире ошибка выжившего проявляется повсюду. В бизнесе мы читаем истории только успешных стартапов и на их основе выводим «рецепты успеха», забывая, что тысячи других следовали тем же рецептам и провалились (просто о них не пишут статьи). В инвестициях люди отмечают удачливых трейдеров и думают: «эта стратегия работает», – хотя десятки других с той же стратегией разорились, выпав из выборки. В повседневной жизни – советчики говорят: «Бросай работу и открывай бизнес, смотри, Билл Гейтс не закончил колледж – и стал миллиардером!» Это совет от выжившего – за каждым Гейтсом стоят тысячи людей, бросивших учёбу и не добившихся ничего похожего. Чтобы не попасть в эту ловушку, всегда спрашивайте: «А кого не видно в этой картине? Чьи голоса молчат?». И помните, что неудачи редко попадают в фокус, хотя их опыт зачастую не менее ценен.

Эвристика доступности (availability heuristic).

Следующая распространённая ошибка – эвристика доступности. Это склонность судить о частоте или вероятности события по тому, насколько легко соответствующие примеры приходят на память . Проще говоря, если вы легко можете что-то вспомнить или представить, вам кажется, что это происходит часто. Мозгу так удобнее – он принимает яркость и свежесть воспоминания за признак значимости.

Возьмём пример: чего люди боятся больше – попасть в авиакатастрофу или разбиться в автомобиле? Многие скажут, что самолёты опаснее, потому что каждый раз, когда случается авиакатастрофа, об этом трубят новости, и эти образы жутко пугающие. Аварии же на дорогах происходят ежедневно и не привлекают столько внимания. В результате в памяти самолётные трагедии занимают куда больше места, чем бесчисленные ДТП, и нам кажется, что летать рискованнее. На самом деле всё наоборот: статистически автомобиль гораздо опаснее. Яркость примера сбивает интуицию: мы переоцениваем риск редких, но громких событий, и недооцениваем вероятность рутинных, но смертельно опасных ситуаций (например, те же аварии или болезни сердца). Психологи отмечают, что такая доступность в памяти ведёт к систематическим ошибкам в оценках .

В бизнес-контексте эвристика доступности тоже проявляется. Допустим, менеджер недавно прочитал статью о кибератаке на компанию и теперь сильно переоценивает риск именно хакерских взломов, при этом игнорируя более вероятные угрозы (скажем, утечку данных из-за человеческой ошибки). Или инвестор, слышавший новости о внезапном обрушении рынка, начинает паниковать и продавать активы, хотя объективные индикаторы стабильны. Всё потому, что ум свежо держит недавний пример, и кажется, будто событие повторится.

Эвристика доступности зачастую питается средствами массовой информации: новости непропорционально освещают редкие сенсации (теракты, авиакатастрофы, скандалы), создавая иллюзию их повсеместности, тогда как об обычных событиях (мирные дни, успешные посадки самолётов, честные чиновники) мы не слышим. Как следствие, наше восприятие мира искажено в сторону драмы. Чтобы смягчить влияние этого искажения, полезно обращаться к статистике и фактам, а не только к тому, что легко вспоминается. Спрашивайте: «Не слишком ли я полагаюсь на один-два случая? Что говорят общие данные?» Это помогает вернуть ощущения риска и частоты ближе к реальности.

Другие распространённые искажения.

Конечно, описанными тремя когнитивные ловушки не ограничиваются. Вот еще несколько весьма распространённых ошибок мышления:

- Эффект уверенности задним числом (hindsight bias) – после события нам кажется, что мы «так и знали, что так и будет». В ретроспективе всё видится очевидным, хотя до случившегося таковым не было. Это искажение мешает учиться на ошибках: вместо анализа мы переписываем историю в собственной памяти. Эксперты по безопасности отмечают, что самонадеянность задним числом – главный враг объективного расследования инцидентов: зная исход, легко сказать «надо было предвидеть», хотя в реальности участники не имели такой информации . Нужно сознательно напоминать себе, что после драки кулаками махать легко, а будущее всегда туманно.

- Эффект Даннинга–Крюгера – некомпетентные люди склонны переоценивать свои способности, тогда как компетентные, наоборот, часто сомневаются в себе. Это приводит к тому, что чем меньше человек знает, тем увереннее он рассуждает. В технологиях и бизнесе можно встретить новичков, которые после поверхностного ознакомления считают себя экспертами и принимают рискованные решения. Лучшее противоядие – обратная связь и проверка временем. Осознание собственной некомпетентности – болезненный, но необходимый шаг к росту.

- Предвзятость подтверждения ожиданий (эффект самозавершения пророчества) – наши убеждения могут влиять на поведение так, что в итоге создают подтверждение самим себе. Например, менеджер, уверенный, что «новый сотрудник неспособный», будет относиться к нему холодно и не давать шансов проявить себя; сотрудник, чувствуя недоверие, начнёт нервничать и действительно ошибаться. Получается замкнутый круг. Осознавая этот эффект, важно давать людям и ситуациям шанс доказать обратное, а не только искать подтверждения своим мрачным ожиданиям.

- Эффект привязки (anchoring) – первая полученная информация «якорит» наше суждение. Например, в переговорах о зарплате первоначальная названная цифра сильно влияет на итоговое соглашение, даже если она случайна. Или прогнозы продаж зачастую «привязаны» к прошлогодним, даже если условия изменились. Чтобы не поддаваться якорям, старайтесь рассматривать диапазон вариантов и обосновывать оценку с нуля, а не отталкиваться от первого числа, попавшего в голову.

Список когнитивных искажений очень широк – психологи насчитывают их десятки. Важно понимать: все люди подвержены им по умолчанию. Это часть нашего ментального оборудования. Но, вооружившись знанием о них, мы можем научиться обходить хотя бы некоторые ловушки.

Коллапсы там, где их не ждут: ошибки в сложных системах.

Рассмотренные когнитивные искажения касаются индивидуального мышления. Но ошибки проявляются и на уровне сложных систем – организаций, экономик, технологических проектов. Причём часто беды случаются не там, где их активно ждали и боялись, а в «слепых зонах». Почему так происходит?

Сложные системы состоят из множества взаимосвязанных частей, и предсказать поведение всей системы очень трудно. Люди же, даже будучи экспертами, склонны переоценивать свою способность предвидеть события и недооценивать вероятность чёрных лебедей – редких и неожиданных событий. Нассим Талеб в книге «Чёрный лебедь» подчеркнул, что редкие непредсказуемые события оказывают колоссальное влияние, а люди задним числом придумывают им простые объяснения, создавая иллюзию предсказуемости . Мы защищаемся от прошлой катастрофы, но следующая приходит с неожиданной стороны. Как говорили в старину, «генералы готовятся к прошлой войне».

Примеры вокруг нас: Финансовый кризис 2008 года – обвал пришёл из сектора ипотечных деривативов, который считался незначительным, тогда как взгляд большинства был обращён совсем в другую сторону. Коллапс Советского Союза – он распался внезапно для большинства наблюдателей; десятилетиями ожидали внешней войны или переворота, а произошёл внутренний экономико-политический крах. Техногенные аварии тоже нередко происходят из-за мелочи, на которую не обратили внимания, потому что все ресурсы бросили на контроль «очевидно» опасных узлов. Катастрофа шаттла «Челленджер» в 1986 году случилась из-за резинового уплотнителя в топливном баке – о его уязвимости инженеры предупреждали, но менеджмент NASA счёл проблему маловероятной, пока трагедия не доказала обратное.

Почему умные системы терпят крах непредсказуемо? Вот несколько причин:

- Скрытые взаимосвязи. В сложной системе компоненты влияют друг на друга нелинейно. Мы можем знать, что каждая часть в отдельности относительно надёжна, но их сочетание может породить непредвиденный эффект домино. Мелкий сбой, распространяющийся через сеть связей, приводит к непропорционально большому коллапсу.

- Человеческий фактор и групповое мышление. В организациях бывает культура, где плохие новости замалчиваются, а сомневающихся подавляют. Групповое мышление приводит к тому, что коллектив переоценивает свои возможности и закрывает глаза на сигналы опасности. Когда все уверены «у нас всё под контролем», именно тогда система наиболее уязвима. Кстати, системные аварии чаще происходят в обстановке излишней самоуверенности. Как писал один эксперт, операторы сложных систем всегда балансируют между продуктивностью и безопасностью, и в спокойные периоды склоняются к продуктивности, пока не случится авария . После аварии все вдруг «знали», где была проблема – это опять же эффект задним числом.

- Неполнота модели. Любая модель риска (финансовая, инженерная) упрощает реальность. Мы можем предусмотреть десятки сценариев, но случится сороковой, не учтённый. Системы, особенно с участием людей, содержат элемент неопределённости и хаоса. Полностью предсказать, где рванет, невозможно. Поэтому коллапс часто воспринимается как «грянувший гром среди ясного неба».

Из-за этих факторов коллапсы происходят в неожиданных местах. Люди защищают систему там, где уже знают о рисках, но атакует судьба по закону подлости в самом слабом звене, которое не распознали. Это не означает, что предвидеть бесполезно – просто нужно признавать ограниченность прогнозов. Инженер и социолог Чарльз Перроу называл такие явления «нормальными авариями» – в очень сложной и тесно взаимосвязанной системе аварии неизбежны со временем, хоть ты тресни. А Талеб советует не столько гадать что и когда случится, сколько строить системы с расчётом на непредсказуемое – повышать устойчивость, иметь запас прочности.

В истории полно уроков: крепость, которую считали неприступной, пала из-за забытой калитки; экономика, славящаяся стабильностью, рухнула от неожиданного шока. Поэтому здоровый подход – не самоуверенно думать, что мы всё учли, а культивировать системный скептицизм и готовность к сюрпризам. Как минимум, полезно поощрять в командах «адвоката дьявола» – роль, в которой человек специально ищет уязвимые места в благостных планах. Такие практики снижают шанс коллективного самообмана.

Как мыслить трезво: практики для обнаружения ошибок и самоисправления.

Раз уж наша познавательная аппаратура полна сбоев, возникает вопрос: что делать? К счастью, зная о типичных когнитивных ошибках, можно внедрить в жизнь ряд практик, которые помогают их выявлять и нейтрализовать. Ниже – несколько методов и подходов, помогающих мыслить более объективно.

- Метод научной проверки гипотез. Старайтесь подходить к убеждениям как учёный: формулировать проверяемые гипотезы и пытаться опровергнуть их, а не подтвердить. Такой настрой, предложенный ещё Карлом Поппером, прямо противоположен нашей натуре, зато спасает от многих иллюзий. Если у вас есть теория («мой проект наверняка заинтересует рынок»), попробуйте найти факты против неё. В науке гипотеза считается крепкой, если прошла проверку на прочность. В жизни – так же: ищите не подтверждения своей правоты, а слабые места своей идеи. Это трудно и иногда неприятно для эго, зато ограждает от провалов. Избавьтесь от мышления типа «я уже решил и ищу аргументы в поддержку» – вместо этого задавайте: «Что бы доказало, что я не прав?».

- Приём «премортем». Этот метод придуман психологом Гэри Кляйном и активно поддерживается Даниэлем Канеманом. Premortem – это мысленный эксперимент: команда или человек представляют, что прошло время и проект провалился, причём провалился катастрофически. А затем генерируют причины – почему так могло произойти . Когда люди думают не «почему мы добьёмся успеха», а «почему мы потерпели фиаско», они внезапно обнаруживают массу слабых мест, которые в оптимистичном режиме не видны. Прелесть упражнения в том, что оно снимает давление согласия: критиковать текущий план обычно некомфортно, а вот описывать гипотетический провал – безопасно, это же «просто воображение». Исследования показывают, что премортем значительно снижает излишнюю уверенность команды по сравнению с обычными обсуждениями рисков. Многие компании внедрили этот метод перед стартом крупных проектов, чтобы выявить неочевидные угрозы и своевременно подстелить соломку.

- Замедление мышления и чек-листы. Помните про две системы мышления? Чтобы избежать ловушек System 1, важно вовремя включать System 2. Практически это значит: в ситуациях, требующих важного решения, не действуйте на автомате. Сделайте паузу, пропишите на бумаге плюсы-минусы, задайте вопросы, запросите данные. Да, это дольше, но оправдано, когда ставка высока. Хорошим инструментом, особенно против рассеянности и ложных предположений, являются чек-листы. В авиации и медицине введение простых чек-листов спасло множество жизней – опытные пилоты и хирурги тоже люди и могут забыть очевидное. Список контроля («проверить то-то, спросить себя о том-то») дисциплинирует мышление и не даёт упустить мелочь, которая может оказаться роковой.

- Выявление когнитивных искажений в моменте. Полезно обучаться распознавать собственные искажения по ходу действия. Например, ловить себя на мысли: «Я сейчас, похоже, игнорирую возражение оппонента – не связано ли это с confirmation bias с моей стороны?». Или: «Меня чересчур пугает эта новость – не срабатывает ли тут availability heuristic?» Такое метакогнитивное упражнение требует практики, но со временем вы начнёте «видеть» свои типичные ошибки. Некоторые люди ведут дневник решений, куда записывают, что решили и почему, а потом спустя время проверяют результат. Это позволяет выявить систематические заблуждения (например: «уж в пятый раз переоцениваю сроки выполнения – привет, ошибка планирования!») и скорректировать подход.

- Внешняя перспектива и “красные команды”. Поскольку мы склонны оправдывать свои убеждения, бывает полезно привлечь внешний взгляд. Попросите коллегу или друга сыграть роль оппонента: «найди изъяны в моей идее». Специально выдвигайте гипотезу, противоположную вашей, и попробуйте её обосновать – это развивает гибкость мышления. В организациях практикуют создание «красных команд» – независимых групп, задача которых критиковать и тестировать стратегию основной команды. Такое противопоставление мнений снижает шанс группового самообмана и позволяет увидеть то, что внутри команды замылилось. Главное – создавать культуру, где несогласие не карается, а ценится. Пускай будет лучше спор в конференц-зале, чем молчаливое движение к ошибке.

- Скептицизм к памяти и восприятию. Как мы обсуждали, память у человека ненадёжна, а восприятие легко обмануть. Поэтому разумно относиться к своим воспоминаниям и чувствам с долей сомнения. Если вы уверены, что «точно помните разговор слово в слово», проверьте – велика вероятность, что вы что-то упустили или исказили. Не полагайтесь на единичные свидетельства – ищите подтверждение из нескольких источников. В юриспруденции давно известно, что свидетельские показания ненадёжны, даже когда человек искренне уверен – нашим воспоминаниям свойственно меняться под влиянием внушений и времени. Психолог Элизабет Лофтус в экспериментах показала, что людям можно внедрить ложное воспоминание о событии, которого не было, и они будут свято верить, что оно реально произошло . Осознание этого факта учит скромности: не всё, что мы помним или чувствуем, – правда. Стоит двоично перепроверять себя: сохранять записи, вести дневник, фотографировать – внешние носители памяти помогут скорректировать внутренние.

- Обучение и постоянная информация. Наконец, развивайте свою осведомлённость о когнитивных науках. Читайте литературу о мышлении, следите за новыми исследованиями. Это не сделает вас неуязвимым для искажений (никто не неуязвим), но вооружит инструментарием для их распознавания. Понимая механизмы, легче заметить их проявления. Кроме того, знание примеров чужих ошибок иногда предостерегает от своих. Регулярно спрашивайте себя: «На основании каких данных я делаю этот вывод? Не играют ли тут роль какие-то стандартные ловушки восприятия?» Такой внутренний диалог – признак систематического критического мышления.

Заключение: ценность системного скептицизма.

Разобрав эпистемологию наших ошибок – от врождённых когнитивных искажений до провалов сложных систем – напрашивается общий вывод. Нам всем необходимо культивировать в себе системный скептицизм. Это не пессимизм и не отрицание всего подряд, а привычка подвергать сомнению первое впечатление, удобную версию событий и даже собственные убеждения. Быть скептиком – значит постоянно помнить о возможности ошибки.

Великий физик Ричард Фейнман говорил: «Первый принцип – не обманывать себя, а ведь именно себя обмануть легче всего». Эта фраза прекрасно передаёт суть системного скептицизма. Мы должны сначала убедиться, что сами себя не ввели в заблуждение, прежде чем отстаивать какую-то идею. Скептицизм дисциплинирует разум: заставляет искать доказательства, требовать воспроизводимости фактов, учитывать альтернативные объяснения. Это не означает жить в вечной неопределённости – просто решения принимаются с оглядкой на проверку и возможную ошибку.

Системный скептицизм ценен и на личном уровне (не даёт впасть в иллюзии или аферы), и на уровне общества (спасает от распространения опасных заблуждений, культов, «пузырей»). Научный прогресс в сущности построен на организованном скептицизме: каждый вывод тестируется, каждый эксперимент повторяется, а коллеги стараются найти изъяны – чтобы в итоге осталось только подтверждённое. Нам стоит перенимать этот подход в повседневной жизни.

Подводя итог: люди ошибаются в познании реальности часто и предсказуемо, но, понимая причины этих ошибок, можно выработать противоядия. Осознавайте эволюционные цели мозга – безопасность, а не истина. Знайте свои когнитивные слабости – от подтверждения своего мнения до иллюзии понимания прошлого. Анализируйте не только успехи, но и провалы – свои и чужие – чтобы не увязнуть в ошибке выжившего. И практикуйте приёмы критического мышления: проверку гипотез, премортем, интеллектуальную честность с самим собой. Это трудный путь, требующий усилий и смирения, зато он ведёт к более ясному пониманию мира. А значит – к лучшим решениям и действиям.

Недаром сказано: «Сомневайтесь в том, что «очевидно» – и вы увидите истину». Привычка сомневаться – не знак слабости ума, а как раз признак его силы. Развивая самостоятельное мышление, мы учимся видеть реальность чуть отчётливее, избавляясь от розовых очков и теней надёжности. В этом и заключается ценность эпистемологии ошибок – она учит нас думать лучше.

Рекомендуемая литература и исследования по теме:

- Дэниел Канеман – «Думай медленно… решай быстро» (2011). Классическая работа нобелевского лауреата о систематических искажениях мышления и разделении на «быстрое» и «медленное» мышление. Обилие примеров исследований когнитивных biases.

- Дэн Ариели – «Предсказуемо иррациональный» (2008). Популярная книга о том, как нелогично мы принимаем решения в экономике и быту. Ариели описывает эксперименты, показывающие наши предубеждения (эффект якоря, эффект бесплатного и др.) – в занимательной форме.

- Кэрол Таврис, Эллиот Аронсон – «Ошибки, которые были допущены (но не мной)» (2007).Исследование феномена самооправдания и когнитивного диссонанса. Авторы объясняют, почему люди упорствуют в заблуждениях, не признают своих ошибок и как это мешает нам учиться.

- Нассим Николас Талеб – «Чёрный лебедь. Под знаком непредсказуемости» (2007). Книга о влиянии редких непредвиденных событий и ограниченности наших прогнозов. Учит относиться скептически к экспертным предсказаниям и строить системы, устойчивые к неожиданностям.

- Нассим Николас Талеб – «Одураченные случайностью» (2001). О том, как мы путаем удачу с навыком и недооцениваем роль случайности в успехах. Полезно для понимания ошибки выжившего и других заблуждений в оценке достижений.

- Кэтрин Шульц – «Быть неправым: приключения на границе ошибки» (2010). Журналистское исследование природы ошибки. Шульц рассматривает, почему мы так ненавидим быть неправыми, как ошибаются даже эксперты и почему признание ошибок – необходимый навык.

- Роберт Триверс – «Обмани себя: как самообман помогает нам выжить» (2011). Книга от биолога-эволюциониста о теории самообмана. Триверс излагает идею, что обманывать самого себя – эволюционно выгодно, и приводит множество примеров самообмана у людей и животных.

- Кристофер Чабрис, Дэниел Симонс – «Невидимая горилла» (2010). О знаменитом эксперименте с гориллой и пяти других «повседневных иллюзиях». Авторы раскрывают, как нас обманывают внимание, память, уверенность и др. Особенно ценна часть о ненадёжности восприятия (иллюзии внимания) и памяти.

- Статьи и работы Амоса Тверски и Даниэля Канемана (1970-е – 1990-е). Если интересует научная база когнитивных искажений – изучите их классические статьи: «Суждения при неопределённости: эвристики и bias-ы» (1974) и др. Именно их исследования заложили фундамент понимания ошибок мышления.

- Исследование Элизабет Лофтус о памяти (1970-е – 2000-е). Для понимания проблем памяти и ложных воспоминаний стоит почитать работы Лофтус. Ключевые темы: эффект формулировки вопроса на память (эксперимент с автомобильной аварией), ложные воспоминания о детстве. Эти исследования показали, насколько наша память реконструктивна и подвержена влиянию.

Этот список – отправная точка. Изучая подобные книги и исследования, вы не только глубже поймёте природу человеческих ошибок, но и, возможно, станете чуть более защищены от них на практике. Помните слова Сократа: «Я знаю, что ничего не знаю» – это и есть здоровый эпистемологический скептицизм, который парадоксальным образом и приближает нас к истине. Всегда стремитесь узнать, где можете ошибаться – и тогда шансы ошибиться в важных вопросах значительно снизятся.