Вступление.

Современный мир опирается на сложные системы – от технологической инфраструктуры до социальных институтов. Мы часто уверены, что понимаем, как эти системы устроены, и готовы к их сбоям там, где ожидаем увидеть слабое место. Но реальность показывает обратное: сложные системы нередко рушатся в самых неожиданных местах, поражая нас непредсказуемыми авариями и кризисами. Почему так происходит? Дело в архитектуре самих систем. Если не понимать принципы устройства сложных систем, мы рискуем строить хрупкие конструкции, которые при первом серьезном испытании дают трещину вовсе не там, где были наши прогнозы. Именно поэтому жизненно важно развивать у себя системное мышление и смотреть на мир через призму архитектурных принципов. В этой статье мы разберемся, почему сложные системы разваливаются не там, где их пытаются укрепить, какие уроки дают громкие катастрофы, и как научиться думать как системный архитектор – проектируя устойчивые, антихрупкие системы, способные выдерживать удары судьбы.

Природа сложных систем: взаимосвязь, нелинейность и уязвимости.

Что делает систему сложной? Прежде всего – взаимосвязь ее элементов. В сложной системе множество компонентов переплетены между собой. Поведение каждого элемента влияет на другие, образуя плотную сеть отношений. В таких условиях поведение всей системы невозможно понять, просто анализируя отдельные части. Например, глобальные цепочки поставок сегодня настолько запутаны, что никто не может с уверенностью предсказать, как скажется закрытие одного завода на другом конце мира . Только случившись, сбой высвечивает, насколько критической была роль казалось бы незаметного узла . Скрытые связи делают систему непрозрачной: мы можем даже не подозревать, какой компонент на самом деле является ключевым, пока он внезапно не выйдет из строя.

Сложные системы также характеризуются нелинейностью. Это значит, что малые воздействия могут приводить к огромным последствиям, и наоборот. В таких системах действуют эффекты усиления: положительные обратные связи способны запустить лавину изменений. Например, паника на финансовом рынке может начать с небольшой новости, но через цепочку взаимосвязанных реакций вылиться в глобальный кризис – классический нелинейный сценарий. Обратные связи – как положительные (усиливающие изменения), так и отрицательные (стабилизирующие) – усложняют прогнозирование. Иногда система долго сохраняет видимое равновесие за счет отрицательных обратных связей, но накапливает при этом напряжение. Затем внезапно срабатывает положительная обратная связь, и система скачкообразно переходит в новое состояние. Так, лес может годами оставаться в стабильном состоянии, пока засуха и жара (накопление напряжения) не создадут условия для молнии – и одна искра вызывает масштабный пожар. Нелинейность означает, что причинно-следственные связи не пропорциональны: один и тот же сбой в разное время может либо почти не повлиять на систему, либо привести к катастрофе в зависимости от контекста и состояния других элементов.

Еще одна черта сложных систем – наличие скрытых уязвимостей и латентных ошибок. В больших системах постоянно присутствуют небольшие сбои, погрешности, дефекты – и это нормально. Многие из них не фатальны сами по себе и остаются незамеченными под поверхностью, пока система работает. Инженер и исследователь Ричард Кук отмечал, что сложные системы содержат постоянно меняющуюся комбинацию скрытых сбоеввнутри . Каждая отдельная неполадка слишком мала, чтобы вызвать коллапс, поэтому считается несущественной. Однако такие латентные дефекты накапливаются. Система зачастую продолжает функционировать, даже будучи частично «сломанной», благодаря запасам прочности и действиям операторов . Это похоже на айсберг: видимая часть – вроде бы все в порядке, а под водой скрыты проблемы. Опасность в том, что при стечении обстоятельств несколько незначительных сбоев могут сложиться вместе и прорвать оборону системы. То, что долго считалось мелочью, внезапно становится спусковым крючком катастрофы. Эти уязвимости часто трудно обнаружить заранее – до аварии не очевидно, как мелкая неисправность может привести к большим неприятностям. Поэтому сложные системы таят сюрпризы: они хрупки в местах, которые не бросаются в глаза.

Наконец, сложным системам присуща эмерджентность – целое больше суммы частей. У системы возникают свойства и поведение, которых нет у отдельных элементов. Классический пример – муравейник: ни один муравей сам по себе не обладает “видением” всей колонии, но вместе они формируют сложную самоорганизующуюся систему. Эмерджентность делает поведение системы непредсказуемым исходя из свойств компонентов. В человеческих организациях взаимодействие людей рождает коллективное поведение (культуру, рыночные тренды, «мудрость толпы» или напротив – безумие толпы), которое невозможно объяснить, лишь изучая отдельных индивидов в вакууме. Это значит, что система может провалиться из-за паттернов взаимодействий, а не из-за отдельно взятых элементов. Например, финансовая модель каждого банка может выглядеть устойчивой, но системный эффект одновременных действий многих банков (скажем, массовая скупка одного типа активов) способен привести всю отрасль к краху.

Таким образом, архитектура сложных систем подразумевает множество запутанных связей, нелинейные динамики, скрытые дефекты и неожиданные групповые эффекты. Любая сложная система по определению непрозрачна и полна неопределенности. Понимание этих свойств – первый шаг к тому, чтобы предвидеть неожиданные точки отказа и укреплять систему разумно.

Причины развала систем: слабые звенья, эффект домино, групповое мышление, иллюзии риска.

Почему же сложные системы ломаются не там, где их ждали? Рассмотрим несколько ключевых причин, вытекающих из природы сложности.

Неочевидные слабые звенья.

Есть пословица: «цепь рвется по самому слабому звену». Но в сложной системе трудно заранее понять, какое звено самое слабое – оно может выглядеть прочным, пока скрытая слабость не проявится. Неочевидные слабые звенья – это компоненты или связи, которые кажутся неважными, а на деле оказываются критичными. Мы можем тратить массу ресурсов на усиление того, что считаем уязвимостью, и упустить из виду другой элемент, выход которого из строя обрушит всю конструкцию.

Примеров предостаточно. В 2003 году масштабный блэкаут обесточил весь северо-восток США и части Канады. Причиной стало то, что в Огайо одна линия электропередачи задела дерево, вызвав каскадное отключение сотен линий и генераторов . Казалось бы, мелочь – неотключенная при росте веток линия – а привела к крупнейшему отключению электричества. Слабое звено оказалось не тем, на которое смотрели операторы. Аналогично, в глобальной логистике до пандемии многие не подозревали, что, скажем, фабрика по производству медицинских компонентов в одной стране является узким горлышком для всего мира. Лишь когда она остановилась, выявилась ее критическая роль – и цепочка поставок посыпалась, как карточный домик . Урок: слабое звено часто определяется не логикой отдельных компонентов, а контекстом – то, как глубоко интегрирован элемент в систему и насколько нет замены на случай его сбоя. Системное мышление требует постоянно задаваться вопросом: «А что произойдет, если вот это перестанет работать?» – даже если «это» выглядит незначительным. Нередко катастрофы происходят из-за пренебрежения мелочами – мелких нарушений, накопленных долгов по техобслуживанию, давно откладываемых «несрочных» исправлений. Со стороны все выглядит нормально, пока внезапно не срабатывает принцип «соломенки, сломавшей спину верблюда» – последний небольшой удар вскрывает давнюю слабость.

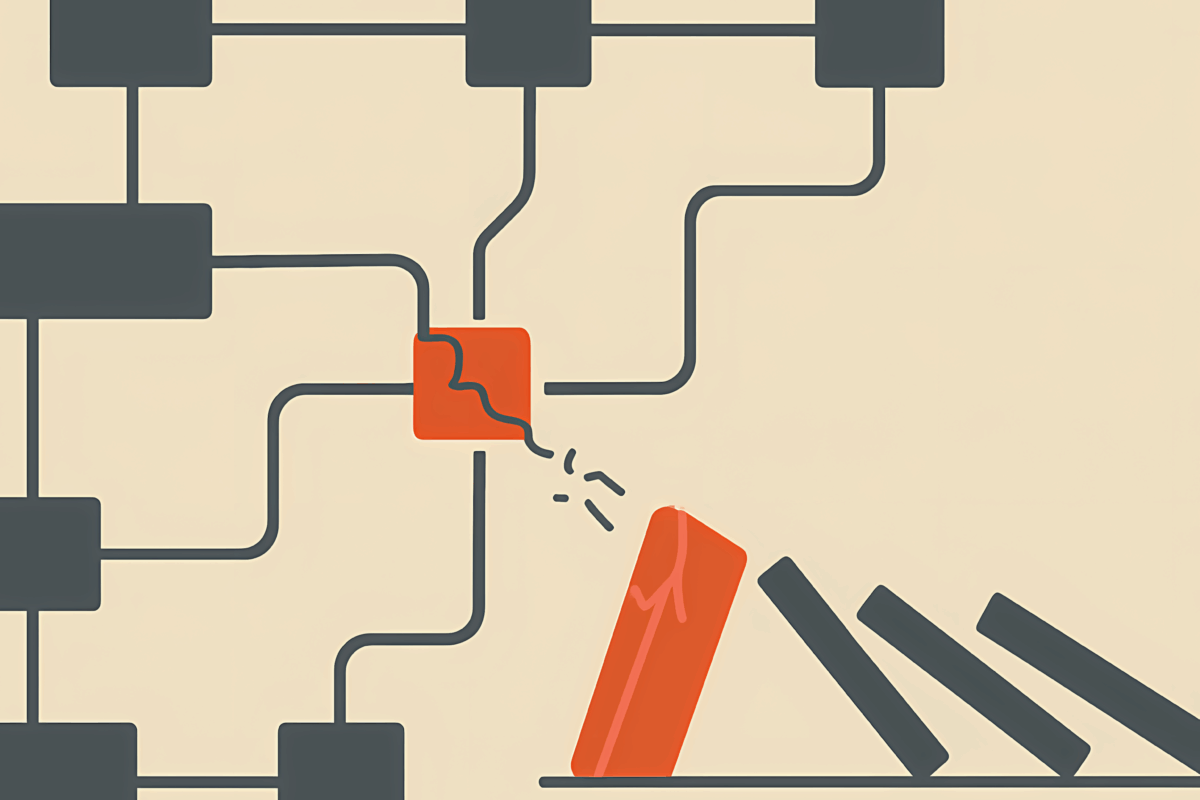

Эффект домино и каскадные сбои.

Сложные системы часто терпят крах не от одного большого удара, а от цепочки последовательных отказов – как падающие домино. Эффект домино означает, что сбой одного элемента запускает череду сбоев других, причем масштаб последствий растет экспоненциально. Это происходит, когда в системе много тесно связанныхкомпонентов без достаточной локализации проблем. В такой ситуации система не умеет «изолировать» аварию: вместо локального сбоя мы получаем лавину.

Исследования аварий показывают, что практически любая катастрофа – результат сочетания нескольких сбоев, ни один из которых по отдельности не был бы фатальным . Защитные механизмы обычно блокируют единичные проблемы. Но когда несколько неполадок случаются одновременно или последовательно, они могут преодолеть барьеры и привести к коллапсу. Эта идея легла в основу модели «швейцарского сыра» в анализе безопасности: каждый уровень защиты имеет отверстия (недостатки), и авария происходит, когда дырки выстраиваются в линию. Проще говоря, одного «домино» недостаточно, чтобы рухнула вся цепь, но несколько домино, падающих одно за другим, довершат дело.

Например, в авиакатастрофах редко бывает одна причина – обычно имеет место сочетание: и технический сбой, и ошибка пилота, и плохая погода, и упущение диспетчеров. Каждый фактор сам по себе мог бы не погубить самолет, но вместе они приводят к трагедии. В 1986 году авария на Чернобыльской АЭС стала следствием целой серии факторов: неудачный дизайн реактора, отключение систем безопасности во время эксперимента, ошибки персонала и отсутствие культуры безопасности – вместе эти условия привели к взрыву . Ни один из этих просчетов поодиночке не обязательно обернулся бы катастрофой. Однако их комбинация создала идеальные условия для цепного процесса: реактор вошел в неустойчивый режим, а нажатие аварийной кнопки (ирония судьбы – попытка спасти ситуацию) из-за конструктивного дефекта только усугубило реакцию, что и вызвало взрыв. Когда много звеньев отказали сразу, система уже не смогла сдержать аварийный процесс.

Эффект домино усугубляется, если система плотно связана и не имеет «перегородок». Тесная связь (tight coupling) означает, что события развиваются стремительно, и компоненты сильно зависят друг от друга. Тормозов нет – один сбой мгновенно передается дальше. В противоположность, если система модульна и слабо связана, то «домино» может упасть, но не задеть соседние костяшки – сбой локализуется. В архитектуре надежных систем специально вводят ограничители распространения отказов: предохранители в электросетях, отсеки на корабле, автоматические клапаны на трубопроводах. Их задача – разорвать цепочку и предотвратить лавину сбоев. Когда таких барьеров нет или они не срабатывают, система летит кувырком целиком. Таким образом, сложные системы разваливаются неожиданно масштабно, если мелкие сбои суммируются и переходят границы, а не тушатся там, где возникли.

Групповое мышление и организационные ловушки.

Не только технические причины ведут к краху систем – человеческий фактор и динамика в организациях тоже играют огромную роль. Одна из коварных причин – групповое мышление. Это феномен, когда группа людей принимает плохо продуманное решение из-за стремления к согласованности и избеганию конфликтов внутри группы. В атмосфере группового мышления критические голоса заглушаются, опасения не высказываются, а риски недооцениваются ради иллюзии единства. В результате организация может двигаться к катастрофе, коллективно игнорируя явные предупреждения.

Классический пример – гибель космического шаттла «Челленджер» в 1986 году. Расследование показало, что за ночь до запуска инженеры-подрядчики предупреждали: резиновые уплотнители (O-ring) на ракетных ускорителях могут потерять эластичность на необычно низкой для Флориды температуре, и это опасно . Однако руководство NASA, испытывая давление уложиться в график и будучи уверенным в прошлых успехах, проявило симптомы группового мышления. Сомнения «аутсайдеров» – инженеров внешней компании – были проигнорированы, решения принимались в узком кругу, настроенном на избыточный оптимизм и самоуспокоенность. Никто не нарушил гармонию команды решительным «Стоп, запускаем при такой температуре нельзя!». В итоге шаттл был запущен, O-ring действительно не справился, и произошёл взрыв сразу после старта, унеся жизни семи астронавтов . Аналогичные динамики группового самообмана прослеживались и в других трагических случаях – от военных операций до корпоративных провалов. Когда команда убеждает сама себя, что “все под контролем” вопреки тревожным сигналам, система становится слепа к своим слабостям.

Групповое мышление ведет к тому, что риски систематически недооцениваются. Возражения не выслушиваются, альтернативные точки зрения вытесняются, а тревожные данные фильтруются, чтобы не нарушать консенсус. В таких условиях организация может пропустить назревающую проблему, даже если отдельные специалисты пытались указать на нее. Особенно опасно это на верхних уровнях управления крупными системами – там, где решения могут предопределить судьбу всей системы. История финансовых компаний полна случаев, когда «все верили, что дела идут отлично» накануне краха, и скептиков увольняли или не пускали наверх. Культура, в которой неудобные вопросы подавляются, – сама по себе архитектурный изъян системы.

Упрощённые модели риска и ложное чувство безопасности.

Еще одна причина неожиданных крахов – неадекватное представление о рисках. Люди склонны упрощать сложность до понятных моделей и чисел. Но упрощённые модели риска могут внушить ложное чувство безопасности, пока реальность не преподнесет суровый урок. В сложных системах риски часто имеют «толстые хвосты» распределения – редкие события случаются чаще, чем предполагают простые статистические модели. Если же мы верим в упрощенную модель (например, что колебания всегда в пределах нормального распределения), то не готовимся к экстремумам. Когда наступает непредсказуемое событие – «черный лебедь» по терминологии Насима Талеба, последствия оказываются разрушительными, а мы – беспомощными, потому что «этого не могло случиться» согласно нашей модели.

Пример – мировой финансовый кризис 2008 года. Большие банки и фонды использовали изощренные математические модели для оценки рисков ипотечных ценных бумаг. Эти модели предполагали, что цены на жилье по всей стране не могут упасть сразу и сильно – ведь такого не наблюдалось в доступной истории. На основе этих уверенных расчетов многие компании набрали колоссальные портфели сложных деривативов, считая их почти безрисковыми. Однако реальность оказалась куда сложнее: корреляции, которых не ожидали, проявились, ипотечный рынок рухнул, и каскад дефолтов прокатился по всему миру. Триггером глобального краха стало событие, которому модели придавали ничтожную вероятность – обвал цен на недвижимость по всей стране. Когда он случился, выяснилось, что рыночные риски были сильно недооценены. Традиционные финансовые модели, основанные на «нормальных» сценариях, попросту не увидели «черного лебедя» . В итоге знаменитые инвестбанки обанкротились или были спасены чудом, а мировая экономика надолго ушла в пике.

Подобные ситуации происходят не только в финансах. Инженерные проекты порой рассчитываются на нагрузки «раз в сто лет», а потом происходят события раз в тысячу лет – плотины смываются рекордным наводнением, здания рушатся от небывалого землетрясения. Планирование на основе прошлого опыта дает иллюзию контроля, но сложные системы генерируют сюрпризы, выходящие за пределы прошлых данных. Упрощённые модели риска склонны выкидывать «неудобные» сценарии, а руководители – верить, что если модель говорит «все нормально», то так и будет. В итоге система оказывается беззащитна перед редким, но возможным событием.

Еще хуже, когда предпринимаются меры безопасности, основанные на неправильных предпосылках. Социолог Чарльз Перроу, изучавший техногенные аварии, отметил парадокс: попытки сделать сложные системы безопаснее часто усложняют их и создают новые способы провала . Например, финансовые деривативы и хедж-фонды были задуманы для снижения рисков на рынке, а в итоге усилили волатильность и масштабы кризисов . Новые технологии в управлении системами могут устранять одни уязвимости, но привносить другие, более неожиданные . Уповая на очередную «умную» систему защиты, операторы могут расслабиться и снизить бдительность – до тех пор, пока не произойдет авария в новом, не предусмотренном сценарии. Ложное чувство безопасности – опаснейший побочный эффект упрощенных моделей и технических «решений», не учитывающих всей сложности. Когда мы верим, что нашли «корень проблемы» и устранили его, природа сложной системы может преподнести удар совсем с другой стороны.

Примеры катастроф и провалов.

Чтобы ощутить все эти принципы на практике, рассмотрим несколько историй реальных системных крахов – в технике, бизнесе и политике. В каждой истории слабое место оказалось не тем, что ожидали, а причины носили комплексный характер.

Техногенная катастрофа: Чернобыльская авария.

Чернобыльская катастрофа 1986 года – один из самых известных примеров, как комплекс факторов и скрытых изъянов привел к непредсказуемому краху. Реактор РБМК-1000, стоявший на Чернобыльской АЭС, считался надежным при соблюдении регламента. Инженеры уверяли, что при любых проблемах реактор можно заглушить нажатием аварийной кнопки АЗ-5, которая вводит все управляющие стержни и останавливает реакцию. Казалось, что худшее, что могло грозить – это остановка реактора. Однако архитектура системы содержала скрытый дефект: конструкция стержней управления имела графитовые наконечники. В определенных условиях – низкая мощность реактора и особое положение стержней – нажатие аварийной кнопки вызывало кратковременный скачок мощности, вместо немедленного снижения. Этот изъян не был очевиден операторам.

Ночью 26 апреля 1986 года персонал проводил эксперимент, требовавший работы реактора на низкой мощности. Из-за ряда ошибок и нарушений процедуры реактор вошел в опасный режим: мощность нестабильно колебалась на низком уровне, часть защит была отключена. Когда операторы осознали, что ситуация выходит из-под контроля, они сделали то, чему их учили – нажали АЗ-5, ожидая безопасной остановки. Но случилось обратное: графитовые наконечники стержней, войдя в активную зону, вытеснили воду-хладагент и вызвали резкий всплеск реактивности. Мощность мгновенно подскочила в десятки раз, ядро разорвало паровой взрыв, за которым последовал химический взрыв графита. Реактор фактически взорвался от действия аварийной системы, на которую возлагали надежду.

Катастрофа была полной неожиданностью. Никто не предполагал, что последней кнопкой, которая должна спасать, окажется триггером взрыва. Система развалилась совсем не там, где ожидали: не из-за внешнего воздействия или явного отказа оборудования, а из-за комбинации человеческих решений и скрытого проектного изъяна. Долгое время авария казалась невозможной – ведь «и дизайн надежный, и персонал подготовлен». Однако, как сформулировали потом эксперты, реактор имел «дефект по умолчанию» – встроенную уязвимость, проявившуюся лишь при определенном стечении обстоятельств. Чернобыль наглядно показал, к чему приводят ложные предположения в архитектуре: уверенность, что аварийные системы гарантированно предотвратят худшее, сыграла злую шутку. Итог – масштабнейшая техногенная катастрофа, экология загрязнена, десятки погибших от лучевой болезни, сотни тысяч эвакуированных, а доверие к атомной энергетике подорвано на десятилетия.

Корпоративный крах: финансовый кризис 2008 года.

В 2008 году мировой финансовой системе нанес удар крупнейший кризис со времен Великой депрессии. Его триггером стал обвал рынка ипотечных кредитов в США, но глубинные причины лежали в структуре финансовой системы и массовых заблуждениях в оценке рисков.

Предшествующие годы казались эпохой процветания: банки придумывали все новые финансовые продукты, кредиты давали направо и налево, прибыли росли. Ключевым элементом стали ипотечные облигации и производные инструменты (CDO, CDS), которые позволяли паковать ипотечные кредиты и продавать их инвесторам по всему миру. Эта система казалась блестящей архитектурой риска: разделение на транши, рейтинговые оценки, диверсификация по регионам – всё указывало, что риск распределен и снижен. Рейтинговые агентства присваивали высоким траншам наивысшие рейтинги AAA, подразумевая минимальный риск невыплаты.

Однако внутри этой сложной конструкции скрывались уязвимости. Кредитные стандарты падали – loans выдавались даже тем, кто вряд ли сможет платить ( ber infamous subprime). Модели риска предполагали, что цены на жилье если и снизятся, то локально. Никто не ожидал общенационального падения – ведь этого не происходило десятилетиями. Вся система была построена на предположении о постоянном росте или хотя бы стабильности рынка недвижимости. Это и было слабым звеном: если рынок пойдет вниз, каскад дефолтов по ипотекам затронет все связанные продукты. Но предупреждения звучали слабо, а те, кто зарабатывал на буме, не хотели их слушать (здесь тоже проявилось некое групповое мышление индустрии – вера, что “новая финансовая инженерия” победила риски).

Когда в 2007-2008 году жилье начало дешеветь и заёмщики стали массово просрочивать платежи, последовала цепная реакция. Обесценились ипотечные облигации, затем фонды, державшие их, столкнулись с паническим изъятием средств. Банкротство одного крупного банка (Lehman Brothers) с колоссальным портфелем этих активов стало спусковым крючком: рынки замерли, кредиты перестали выдаваться – никто не понимал, кто следующий. Финансовая система оказалась настолько взаимосвязана, что проблемы в одном сегменте (ипотечном) перекинулись на весь банковский сектор мира. Инвестиционные гиганты рушились за дни. Государствам пришлось срочно вмешиваться, вливая триллионы долларов, чтобы остановить полное обрушение.

Почему этот крах был «не там, где ждали»? Потому что все готовились к борьбе с видимыми рисками (волатильность рынков, инфляция и т.д.), а настоящая опасность таилась в структуре новых финансовых продуктов. Архитекторы системы создали сложный «замок из деривативов», и были уверены в его прочности благодаря моделям и рейтингам. Удар пришелся с другой стороны: снизу, от рядовых заемщиков, которые просто не могли платить по кредитам. Социальный фактор (массовая неплатежеспособность), помноженный на финансовый рычаг и взаимосвязи, привел к коллапсу топ-уровня. Рухнуло не только несколько банков – пошатнулось доверие к финансовой системе в целом. Этот кризис научил, что сложные глобальные системы могут пасть жертвой собственных непонятных конструкций, и что модели риска – лишь модели, не гарантирующие реальной устойчивости. После 2008 регуляторы ввели стресс-тесты банков и повышенные требования к капиталу, осознав, что система должна выдерживать крайние сценарии, которые раньше считались «практически невозможными».

Как учиться думать через архитектуру: принципы построения надежных систем.

Приведенные примеры показывают: понимать архитектуру системы – значит видеть ее целостно, с учетом связей, динамики и возможных сценариев. Как же выработать у себя мышление системного архитектора, чтобы проектировать устойчивые системы и предвидеть их уязвимости? Сформулируем основные принципы.

1. Мышление о целом вместо частей. Уметь подняться над деталями и взглянуть на систему целиком – ключевой навык. Вместо того чтобы оптимизировать отдельный компонент, спросите: какую роль он играет в общей конструкции? Какие связи его связывают с другими элементами? Системный подход требует видеть картину в целом, а не только свою «тесную специализацию». Архитектор системы всегда держит в уме схему связей: что с чем взаимодействует, где информация или материал перетекает, где могут возникнуть замкнутые петли. Этот принцип противостоит узкому «туннельному» видению, из-за которого многие и упускают скрытые слабые места. На практике полезно рисовать схемы, диаграммы, карты влияний, чтобы явными сделать даже неочевидные связи. Видеть невидимые нити – первое правило системного мышления.

2. Принцип резервирования и отказоустойчивости. Устойчивые системы имеют запас прочности и дублирующие элементы. Архитектурно это выражается в том, что нет единственной точки отказа (single point of failure). Если один элемент выйдет из строя, его функции временно берет на себя другой. В инженерии это резервные серверы, аварийные генераторы, запасные каналы связи. В менеджменте – подготовленные замены ключевым сотрудникам, диверсификация поставщиков, страховые фонды. Природа тоже использует резервирование: у нас две почки, два глаза – на случай потери одного. Закладывайте избыточность. Да, дублирование кажется дорогим и «неэффективным» с точки зрения максимальной экономии – зато в час X оно спасает систему от коллапса. Этот принцип также называют принципом отказоустойчивости: система проектируется так, чтобы функционировать (хотя бы в ограниченном режиме) даже при выходе из строя части компонентов. Например, интернет задумывался военными США с идеей маршрутизации вокруг поврежденных узлов – сеть должна пережить разрушение нескольких центров. Проверяйте свои проекты: какое звено в них самое уязвимое? Что если его не станет? Если ответ – «тогда всё рухнет» – стоит срочно вводить резерв или перераспределять функции.

3. Запас прочности и буферы. Закладывать больше, чем требуется по норме – это классический принцип надежности. Инженеры всегда вводят коэффициент запаса: мост, рассчитанный на максимальную нагрузку 100 тонн, построят на 150 тонн, чтобы непредвиденное не привело к обрушению. Аналогично, финансово устойчивая семья имеет сбережения не только на плановые расходы, но и на непредвиденные – «подушку безопасности». Запас прочности означает наличие буферов, резервов, свободного пространства для маневра, когда условия внезапно ухудшатся. Системы без запаса – на пике эффективности – очень уязвимы. Как писал Н.Н. Талеб, избыточная оптимизация делает систему хрупкой. Длительное отсутствие сбоев парадоксально снижает готовность к сбою , потому что все «лишнее» убирается как неэффективное. Например, компания, которая ради прибыли работает just-in-time без складских запасов, очень эффективна в нормальные времена – но первая же задержка поставок остановит производство. Антихрупкое мышление учит ценить резерв и избыточность. Лучше чуть менее эффективно, но более живуче. Этот принцип тесно связан с предыдущим: резервирование – это один из видов запаса прочности. Также запас бывает во времени (например, закладывать дополнительные сроки в проектах на случай задержек) или в производительности (серверы загружены не на 100%, чтобы выдержать пик). Системный архитектор всегда спросит: как далеко система от предела? Что если нагрузка вырастет на 20%? – и спланирует емкость с запасом.

4. Модульность и локализация ошибок. Чтобы избежать эффекта домино, система должна быть структурно разделена на модули с четко определенными интерфейсами. Если один модуль выходит из строя, это не должно мгновенно парализовать остальные. В программировании такой подход известен как isolation, sandboxes – ограничение влияния части системы. В организации – это автономные команды или подразделения, способные работать некоторое время независимо. Тесная связность – враг устойчивости. Архитектурно стоит стремиться к слабо связанным системам (loose coupling), где взаимодействия между компонентами минимально необходимы. Тогда сбой внутри одного блока не сразу ударяет по другим – есть шансы его отловить и локализовать. Пример – корабль, поделенный на водонепроницаемые отсеки: пробоина в одном отсеке не топит весь корабль сразу. В электроэнергетике – отсечки сети автоматическими выключателями. В экосистемах – биомы разделены природными барьерами, потому эпидемии не уничтожают все живое разом. Делите системы на части и ограничивайте распространение ошибок. Это принцип «fail safe»: компонент должен по возможности отказывать безопасно, не повреждая других. Например, плавкий предохранитель в приборе – он сознательно слабое место, которое сгорает первым и тем самым спасает остальную схему от перегрузки. Планируя систему, думайте: «А если этот модуль сломается, что он потянет за собой?» Если ответ – «много чего вокруг», значит стоит пересмотреть архитектуру, добавить буферы, шлюзы или клапаны, закрывающие путь аварии.

5. Простота и прозрачность. Избыточная сложность – питательная среда для неожиданных сбоев. Каждый дополнительный слой, каждое сложное устройство – это новые потенциальные точки отказа и новые неизвестные взаимодействия. Системный архитектор стремится к принципу KISS (Keep It Simple, Stupid) – насколько возможно упрощать конструкцию без потери функций. Простая система легче понимается, ее слабые места проще выявить, а пользователи не запутаются в ней. Разумеется, не любую сложность можно убрать, но часто системы растут комками спагетти из-за эволюции, интеграции многих частей. Нужно постоянно рефакторить и оглядываться: где можно упростить? где убрать лишнее звено? Прозрачность системы – чтобы было понятно, как она работает – тоже критично. Если даже разработчики или операторы не до конца понимают внутреннюю логику, ждать беды. Так случилось с финансовыми CDO – они были столь сложны, что даже эксперты толком не понимали, что внутри. Итог – массовое недооценивание риска. Простая ≠ примитивная: иногда лучше более простое, но надежно работающее решение, чем супер-умное, но непрозрачное. Минимализм в архитектуресокращает скрытые дефекты.

6. Гибкость и адаптивность. Устойчивость != неподвижность. Наоборот, самые живучие системы – гибкие и умеют адаптироваться. Здесь вступает понятие антихрупкости: способность не просто выдерживать удары, но и становиться сильнее благодаря им . Как этому способствует архитектура? Закладывая в систему механизмы обучения и эволюции. Например, в организациях должна быть обратная связь от инцидентов: произошла ошибка – вносятся изменения, чтобы она не повторилась. В технических системах – самокоррекция, алгоритмы перестройки при изменении условий. Антихрупкая система выигрывает от стресса – например, наш иммунитет укрепляется после небольших доз инфекции (вакцинация по сути и есть управляемый микростресс). Принцип для архитектора: давать системе иногда надёжно «потрястись», чтобы выявить слабые места и «привить иммунитет». Гибкость также подразумевает деконцентрацию контроля – децентрализованные системы более живучие, так как могут перестраиваться локально. В природе – распределённая экосистема, в экономике – принцип локальной автономии (франчайзинг, отделения). Если центр повержен, периферия может выжить и восстановить. Поощряйте адаптивность: закладывайте возможность сценариев «что если», альтернативные пути, обучаемые компоненты. Не рассчитывайте, что один план навсегда верен – система должна иметь план Б и план В, и умение переключаться.

7. Учет человеческого фактора и культуры. Как бы ни была хороша техническая архитектура, люди могут ее либо укрепить, либо подорвать. Поэтому системный подход включает проектирование не только машин, но и процессов, правил, культуры взаимодействия. Создавая организацию или проект, нужно встроить механизмы, предотвращающие групповое мышление и способствующие раскрытию проблем. Например, культура открытости, blameless post-mortems (разборы полетов без поиска «козла отпущения», а для обучения), ротация ролей, независимые аудиторы – всё это элементы архитектуры организации. Безопасность – свойство не компонента, а всей системы и культуры . В авиации внедрена культура Crew Resource Management: младший пилот обязан говорить старшему о замеченных ошибках – чтобы избежать эффекта «капитан всегда прав». Аналогично, в компаниях полезно структурировать решение так, чтобы звучали альтернативные мнения (например, метод «назначенного скептика» или devil’s advocate на совещании). Учтите человеческие слабости в архитектуре: от усталости (ограничение рабочего времени) до склонности к риску (разделение критических решений между несколькими лицами). Архитектура системы должна предусмотреть, как люди будут с ней взаимодействовать, и предотвратить условия, где человеческий фактор приведет к беде. Самый блестящий проект может рухнуть, если им управляют люди без нужных знаний или мотивации – значит, обучением и подбором кадров тоже нельзя пренебрегать. Вовлекайте человеческий элемент как часть системы, а не внешний раздражитель.

Эти принципы – не догма, а ориентиры для мышления. Главное – мыслить превентивно, закладывая устойчивость на этапе проектирования, а не реагировать постфактум. Системный архитектор постоянно задает «что если…?» и прорабатывает, как система поведет себя при различных неблагоприятных обстоятельствах. Такая ментальная привычка формирует более надежные конструкции и снижает шансы сюрпризов.

Практические методы: стресс-тесты, анализ слабых звеньев, модели отказов.

Знать принципы – одно, но как применить их на практике для существующих или планируемых систем? Вот несколько практических методов системного мышления, которые помогают выявлять скрытые проблемы и укреплять архитектуру:

- Стресс-тестирование системы. Не ждите реального кризиса – смоделируйте его искусственно. Стресс-тест – это проверка системы экстремальными условиями, выходящими за рамки обычных. Финансовые организации регулярно проходят стресс-тесты: регулятор проверяет, выдержит ли банк сценарий глубокой рецессии, массового оттока вкладчиков и т.п. По результатам выявляются узкие места – например, что капитала не хватит, если случится то-то, – и банк вынужден усиливаться. В инженерии стресс-тесты тоже в ходу: новое изделие испытывают на максимальных нагрузках, чтобы увидеть, где наступает отказ. В IT-инфраструктуре практикуется даже chaos engineering – намеренное внесение сбоев. Знаменитый инструмент Netflix Chaos Monkey случайным образом «вырубает» серверы в продакшене, чтобы убедиться, что сервис продолжит работать . Такая агрессивная методика сначала шокирует, но доказала свою эффективность: нарочно ломая систему малыми дозами, мы учим ее быть устойчивой к реальным потрясениям . Применить стресс-тестирование можно в любых проектах: провести учения, симуляции аварий, внезапные проверки резервного канала. Главное – не верить слепо, что система справится, а проверять это практикой. Стресс-тест высвечивает, что конкретно сломается первым, если «надавить» на систему – и дает шанс исправить это превентивно.

- Анализ слабых звеньев (поиск «single point of failure»). Соберите команду (или самостоятельно) и тщательно разберите структуру системы на предмет того, где единственная точка отказа может обрушить всё. Это может быть технический компонент (единственный сервер с базой данных), человек (незаменимый сотрудник, без которого работа встанет), процесс (если пропустить один шаг, клиент останется без услуги). Целенаправленно задавайте вопрос: «Что самое худшее случится, если Х выйдет из строя / перестанет работать / не придет?». Если ответ – «срыв критической функции», то Х – кандидат на усиление или дублирование. Часто полезно составить таблицу рисков: перечислить ключевые элементы и оценить влияние их отказа на систему (катастрофическое, среднее, малое) и вероятность такого отказа. В фокус попадают компоненты с высоким влиянием и ненулевой вероятностью. Далее придумываем меры: резервирование, альтернативы, планы действий. Например, обнаружили, что вся разработка ПО держится на одном старшем программисте – риск огромный. Решение: срочно поднять уровень команды, задокументировать его знания, распределить ответственность. Или выяснилось, что завод работает от одной подстанции – провести вторую линию электропитания, установить генераторы. Метод «что будет, если…» кажется очевидным, но его часто ленятся применять системно. Хороший архитектор ментально «выдергивает» по очереди разные кирпичики конструкции и смотрит, развалится она или устоит. И только убедившись, что нет смертельного кирпичика, спокойнее спит.

- Моделирование и сценарный анализ отказов. Этот метод близок к стресс-тесту, но упор на мысленное (или программное) моделирование разных сценариев. Например, метод Pre-mortem (предварительное «вскрытие»): команда представляет, что проект провалился, и проводит мозговой штурм – почему это могло случиться. Такой мысленный эксперимент, предложенный психологом Гэри Кляйном, позволяет выявить слабые места, о которых в обычном обсуждении никто бы не упомянул (неудобно же думать о провале). В инженерии применяют Failure Mode and Effects Analysis (FMEA) – анализ видов отказов и их последствий. Расписываются все возможные точки, где компонент может отказать, и какие последствия это повлечет для всей системы. Затем каждому сценарию присваивается критичность, и придумываются меры профилактики или защиты. Диаграммы отказов (Fault Tree Analysis) рисуют как дерево: вершина – общий отказ системы, ветви – комбинации событий, приводящие к нему. Такие модели помогают понять, какие комбинации сбоев самые опасные. В сложных системах также используются симуляции Монте-Карло – многократное случайное проигрывание работы системы при различных исходных условиях и сбоях с заданной вероятностью, чтобы статистически оценить надежность. Для организационных и социальных систем удобен сценарный анализ: описываются несколько гипотетических будущих ситуаций (оптимистичный, базовый, кризисный, катастрофический) – и оценивается, как система будет функционировать в каждом. Это позволяет подготовиться к неблагоприятным вариантам, а не только планировать исходя из розовых очков. Смысл всех этих методов – заранее представить и «проиграть» аварии на бумаге или в компьютере, чтобы в реальности им предотвратить или смягчить удар.

- Обратная связь и обучение на ошибках. После каждого инцидента, даже небольшого сбоя, разбирайте причины и дорабатывайте систему. Это превращает реальные удары судьбы в уроки для улучшения – превращает вашу систему из просто устойчивой в антихрупкую, которая становится сильнее от испытаний. В авиации любой серьезный инцидент (даже без жертв) расследуется, и рекомендации рассылаются по всему миру, чтобы другие учли. Компании в секторе технологий практикуют post-incident review: когда, скажем, сервер упал на час, потом команда пишет подробный отчёт – почему, что сделали, как избежать повторения. Важно не искать крайнего, а понять системную причину – например, не обвинять оператора, а признать, что инструкция была неполна, и исправить её (или доработать интерфейс, чтоб ошибка больше невозможна технически). Такая среда постоянного обучения делает систему гибче и прочнее. Игнорирование же «звоночков» приводит к тому, что рано или поздно случается большая беда. Как говорил Ричард Кук, безотказная работа требует опыта отказов – чтобы знать границы системы и как не выходить за них. Поощряйте культуру, где о проблемах сообщают открыто, а не скрывают их. Это позволит системе самосовершенствоваться.

Внедряя эти методы, вы постепенно приучаете себя и организацию думать проактивно и архитектурно. Стресс-тесты и сценарии расширяют видение, анализ слабых звеньев дисциплинирует дизайн, а обратная связь обеспечивает эволюцию. Конечно, не все риски можно предугадать – но применение системного подхода значительно снижает вероятность катастрофических сюрпризов. Вы начинаете видеть систему как живой организм, который надо тренировать, закалять и лечить, а не считать неуязвимой машиной.

Заключение: мышление системного архитектора.

Системное мышление – это интеллектуальный стиль, который постоянно ищет целостную картину, причинно-следственные сети и долгосрочные последствия. Мышление системного архитектора – на порядок глубже мышления узкого специалиста. Архитектор сложной системы чувствует ответственность за всю конструкцию целиком: и за прочность каждого элемента, и за надежность связей, и за взаимодействие с внешней средой. Он должен быть и инженером, и социологом, и психологом в каком-то смысле – учитывая и физические факторы, и человеческие.

Основная мысль, которую стоит вынести: сложные системы не прощают легкомысленного отношения. Если при проектировании или управлении думать лишь о том, как добиться цели при идеальных условиях, система почти наверняка провалится при реальных, далеких от идеала обстоятельствах. Качественная архитектура всегда предусматривает «что-то пойдет не так» – потому что рано или поздно так и будет. Системный архитектор чуть-чуть параноик: видит потенциальную аварию там, где остальные видят «незначительную деталь». Но именно такая предусмотрительность отличает устойчивые организации, инфраструктуры и сообщества от тех, которые распадаются при первом же кризисе.

Однако просто быть осторожным недостаточно. Важно еще и уметь создавать условия для развития и адаптации. Мир меняется, и системы должны меняться вместе с ним. Антихрупкость – вот качественное новое слово в нашем лексиконе, суть которого – получать пользу от хаоса. Мы должны научиться строить системы, которые не просто выдерживают шторм, а становятся сильнее благодаря ему. Это требует постоянно учиться на опыте – и чужом, и своем – и закладывать этот опыт в обновление принципов и конструкции.

Подумайте на мгновение: в вашей работе, вашем бизнесе, вашем городе – какие есть скрытые зависимости или слабые звенья? Где предполагается, что «такого не случится», но если случится – последствия будут тяжелыми? Эти вопросы должен регулярно задавать себе каждый, кто отвечает за что-то сложнее карандашного стаканчика. Не для того, чтобы жить в страхе, а чтобы превентивно укреплять систему. Выявили уязвимость – отлично, это шаг к улучшению, а не повод замалчивать. Внедрили резерв – возможно, он никогда не понадобится, и слава богу, зато вы спокойны. Проверили систему тестом – нашли баг, исправили, и когда настанет настоящий стресс, вы его пройдете без катастрофы.

Мышление системного архитектора – это привычка смотреть шире и глубже, видеть связи и предугадывать следствия. Это стремление к элегантной простоте вместо бездумной сложности. Это уважение к фактору неопределенности и умение держать баланс между эффективность сейчас и устойчивостью в будущем. Развивая такое мышление, мы не только предотвращаем падения домов, мостов, серверов или организаций – мы открываем путь к созданию систем, которые процветают в условиях хаоса, направляя энергии изменений себе на пользу.

Сложные системы будут всегда – чем развивается цивилизация, тем они хитрее. Поэтому и нам придется становиться умнее, системнее, чтобы ими управлять. Пусть же каждая неожиданная поломка будет для нас уроком, а не поражением. Архитектурный подход позволит превратить «неожиданные» крахи во вполне ожидаемые и предусмотренные препятствия, которые можно обойти или переждать. Кто предупрежден – тот вооружен: понимая архитектуру систем, мы предупреждены о их слабостях. А значит – сможем построить более надежный мир, шаг за шагом.

Список рекомендуемой литературы и исследований:

- Нассим Н. Талеб – «Антихрупкость. Как извлечь выгоду из хаоса». Концепция антихрупкости систем, которые крепнут от стрессов, и размышления о том, как применять этот подход в разных сферах.

- Нассим Н. Талеб – «Черный лебедь. Под знаком непредсказуемости». О редких и непредсказуемых событиях, которые имеют огромные последствия, и почему мы их не ожидаем.

- Донелла Медоуз – «Системное мышление. Как создавать и улучшать системы в бизнесе и жизни»(Thinking in Systems). Классическое введение в понятия систем, взаимосвязей, обратных связей, с массой примеров.

- Питер Сенге – «Пятая дисциплина: искусство и практика самообучающейся организации». Книга о системном мышлении в управлении организациями, как видеть целое и преодолевать «учебные инвалидности» организаций.

- Чарльз Перроу – «Normal Accidents: Living with High-Risk Technologies» (“Нормальные аварии”). Исследование о том, почему в сложных и плотно связанных системах аварии неизбежны как класс явлений, и как с этим жить. Вводит понятие «нормальной аварии».

- Дитрих Дёрнер – «Логика неудачи. Книга о стратегическом мышлении в сложных ситуациях». Исследование психологических причин, почему люди ошибаются, пытаясь управлять сложными системами, и как улучшить наше мышление.

- Ричард Кук – «How Complex Systems Fail» (“Как рушатся сложные системы”). Короткий эссе из 18 выводов об особенностях сложных систем и характере их отказов, основанный на анализе аварий в медицине и инженерии.

- Сидни Деккер – «Drift into Failure» (“Скольжение к провалу”). О том, как крупные катастрофы часто являются результатом постепенного накопления мелких отклонений, воспринимаемых как норма, и как организация незаметно дрейфует к грани.

- Chris Clearfield, András Tilcsik – «Meltdown: Why Our Systems Fail and What We Can Do About It». Современная книга с разборами различных сбоев – от банковских кризисов до аварий – с акцентом на комплексность и практики предотвращения.

- Джон Галль – «Системантика, или Как не работают системы» (Systemantics / The Systems Bible). Нестандартный взгляд на системные провалы в юмористической форме, содержащий мудрые наблюдения (например, закон Галла: «Комплексная система, работающая, неизбежно выросла из простой рабочей системы»).